El chatbot Business Advice AI de la ciudad de Nueva York insta a las personas a infringir la ley

[ad_1]

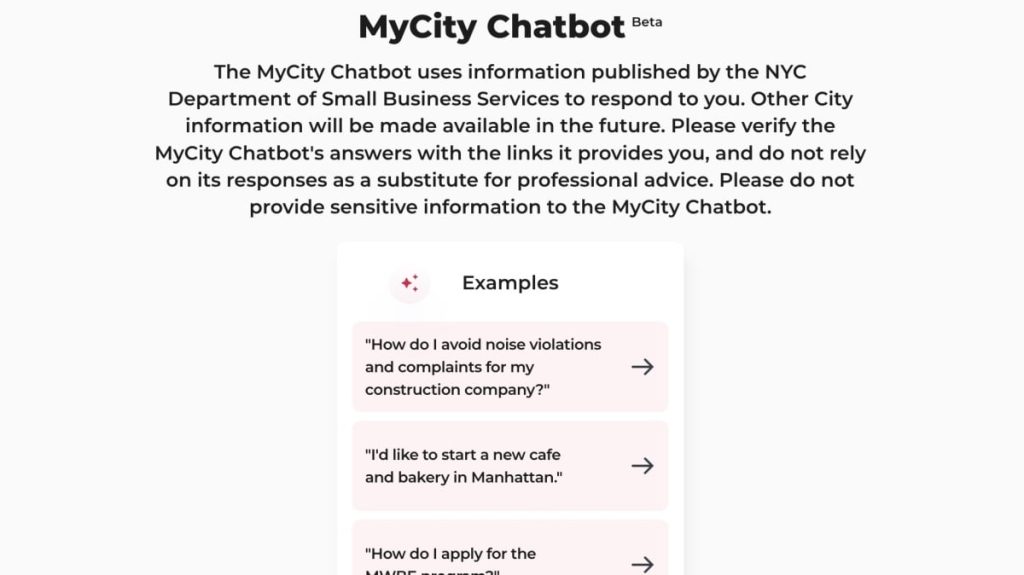

MyCity, el chatbot de inteligencia artificial de la ciudad de Nueva York, ha tenido un comienzo difícil. El gobierno de la ciudad introdujo la tecnología hace cinco meses para ayudar a los residentes interesados en administrar un negocio en la Gran Manzana a encontrar información útil.

Si bien el bot estará encantado de responder a tus preguntas con respuestas aparentemente legítimas, una investigación realizada por The Markup ha descubierto que el bot miente... y mucho. Por ejemplo, cuando se le pregunta si un empleador puede aceptar una parte de las propinas de sus empleados, el robot responde "sí", a pesar de que la ley dice que los jefes no pueden aceptar propinas de sus empleados. Cuando se le pregunta si los edificios están obligados a aceptar vales de la Sección 8, el robot responde "no", aunque los propietarios no pueden discriminar según la fuente de ingresos de un posible inquilino. Cuando se le pregunta si puede hacer que su negocio no utilice efectivo, el robot responde: Adelante, aunque las tiendas sin efectivo están prohibidas en la ciudad de Nueva York desde principios de 2020, y dice: "En la ciudad de Nueva York, no existen regulaciones que exijan a las empresas "Aceptar efectivo como pago", eso está lleno de tonterías.

Para crédito de la ciudad, el sitio web advierte a los usuarios que no confíen únicamente en las respuestas del chatbot en lugar del asesoramiento profesional y que verifiquen todas las declaraciones realizadas a través de los enlaces proporcionados. El problema es que algunas respuestas no contienen ningún enlace, lo que hace aún más difícil comprobar si las afirmaciones del bot son objetivamente correctas. Esto plantea la pregunta: ¿a quién está destinada esta tecnología?

La IA es propensa a sufrir alucinaciones

Esta historia no sorprenderá a nadie que haya seguido los desarrollos recientes en IA. Resulta que a veces los chatbots simplemente inventan cosas. Se llama alucinar: los modelos de IA entrenados para responder a las solicitudes de los usuarios evocarán con confianza una respuesta basada en sus datos de entrenamiento. Porque estas son redes Entonces complicado, es difícil saber exactamente cuándo o por qué un robot inventará una pieza de ficción en particular en respuesta a su pregunta, pero sucede con frecuencia.

En realidad no es la ciudad de Nueva York. Error que su chatbot alucina con que puede extraer consejos de sus empleados: su bot se ejecuta en Azure AI de Microsoft, una plataforma de inteligencia artificial común que empresas como AT&T, Reddit y Volkswagen utilizan para diversos servicios. La ciudad probablemente pagó por el acceso a la tecnología de inteligencia artificial de Microsoft para impulsar su chatbot en un esfuerzo honesto por ayudar a los neoyorquinos interesados en iniciar un negocio, solo para descubrir que el bot era completamente falso. Las respuestas a preguntas importantes alucinan.

¿Cuándo cesan las alucinaciones?

Es posible que estas desafortunadas situaciones pronto queden atrás: Microsoft tiene un nuevo sistema de seguridad para proteger a los clientes del lado oscuro de la IA. Además de las herramientas que evitan que los piratas informáticos utilicen su IA como una herramienta maliciosa y evalúan posibles vulnerabilidades dentro de las plataformas de IA, Microsoft está introduciendo la detección de conexión a tierra, que puede escuchar posibles alucinaciones e intervenir cuando sea necesario. (“Sin conexión a tierra” es otro término para alucinación).

Si el sistema de Microsoft detecta una posible alucinación, puede permitir a los clientes comparar la versión actual de la IA con la versión que existía antes de su implementación. Señale la afirmación alucinada y verifíquela o realice una “edición de la base de conocimientos”, que presumiblemente le permitirá editar el conjunto de entrenamiento subyacente para eliminar el problema. Vuelva a escribir la declaración alucinada antes de enviársela al usuario. o evaluar la calidad de los datos de entrenamiento sintéticos antes de usarlos para generar nuevos datos sintéticos.

El nuevo sistema de Microsoft se ejecuta en un LLM separado llamado Natural Language Inference (NLI), que evalúa constantemente las afirmaciones de IA en función de los datos de origen. Dado que el sistema de verificación de datos del LLM es en sí mismo un LLM, ¿no podría el NLI estar alucinando con su propio análisis? (¡Probablemente! Estoy bromeando, estoy bromeando. Más o menos).

Esto podría significar que organizaciones como la ciudad de Nueva York que potencian sus productos con Azure AI podrían tener un LLM en tiempo real que elimine las alucinaciones en este caso. Si el chatbot MyCity intenta decir que puede operar un negocio sin efectivo en Nueva York, el NLI puede corregir rápidamente el reclamo para que lo que usted, como usuario final, vea sea la respuesta real y precisa.

Microsoft acaba de lanzar este nuevo software, por lo que aún no está claro qué tan bien funcionará. Sin embargo, si es neoyorquino o utiliza un chatbot administrado por el gobierno para encontrar respuestas a preguntas legítimas, debe tomar esas respuestas con cautela por ahora. No creo que "¡el chatbot de MyCity dijo que podía!" se sostenga en los tribunales.

[ad_2]

Deja una respuesta