[ad_1]

Desde limpiar derrames hasta servir comida, se está enseñando a los robots a realizar tareas domésticas cada vez más complicadas. Muchos de estos aprendices de robots domésticos aprenden por imitación; Están programados para imitar los movimientos a través de los cuales un humano los guía físicamente.

Resulta que los robots son excelentes imitadores. Pero a menos que los ingenieros también los programen para adaptarse a cada posible golpe e impacto, los robots no necesariamente sabrán cómo manejar estas situaciones a menos que comiencen su tarea desde arriba.

Ahora los ingenieros del MIT quieren darles a los robots un poco de sentido común cuando se enfrenten a situaciones que los desvíen de su camino habitual. Han desarrollado un método que combina datos de movimiento de robots con el conocimiento de «sentido común» de los modelos de lenguaje grande (LLM).

Su enfoque permite a un robot dividir lógicamente muchas tareas domésticas determinadas en subtareas y adaptarse físicamente a las interrupciones dentro de una subtarea, lo que permite que el robot continúe sin tener que comenzar una tarea de nuevo, y sin requerir que los ingenieros programen explícitamente para corrija todos los errores posibles en el camino.

“El aprendizaje por imitación es un enfoque común que permite a los robots domésticos. Pero cuando un robot imita ciegamente las trayectorias de un ser humano, se pueden acumular pequeños errores y eventualmente descarrilar el resto de la ejecución, dice Yanwei Wang, estudiante de posgrado en el Departamento de Ingeniería Eléctrica y Ciencias de la Computación (EECS) del MIT. «Nuestro método permite que un robot autocorrija los errores de ejecución y mejore el éxito general de la tarea».

Wang y sus colegas describen su nuevo enfoque en un estudio que presentarán en la Conferencia Internacional sobre Representaciones del Aprendizaje (ICLR) en mayo. Los coautores del estudio incluyen a los estudiantes graduados de EECS Tsun-Hsuan Wang y Jiayuan Mao, Michael Hagenow, becario postdoctoral en el Departamento de Ingeniería Aeroespacial del MIT (AeroAstro), y Julie Shah, profesora HN Slater de Ingeniería Aeroespacial e ingeniería aeroespacial en el MIT.

Tarea de idioma

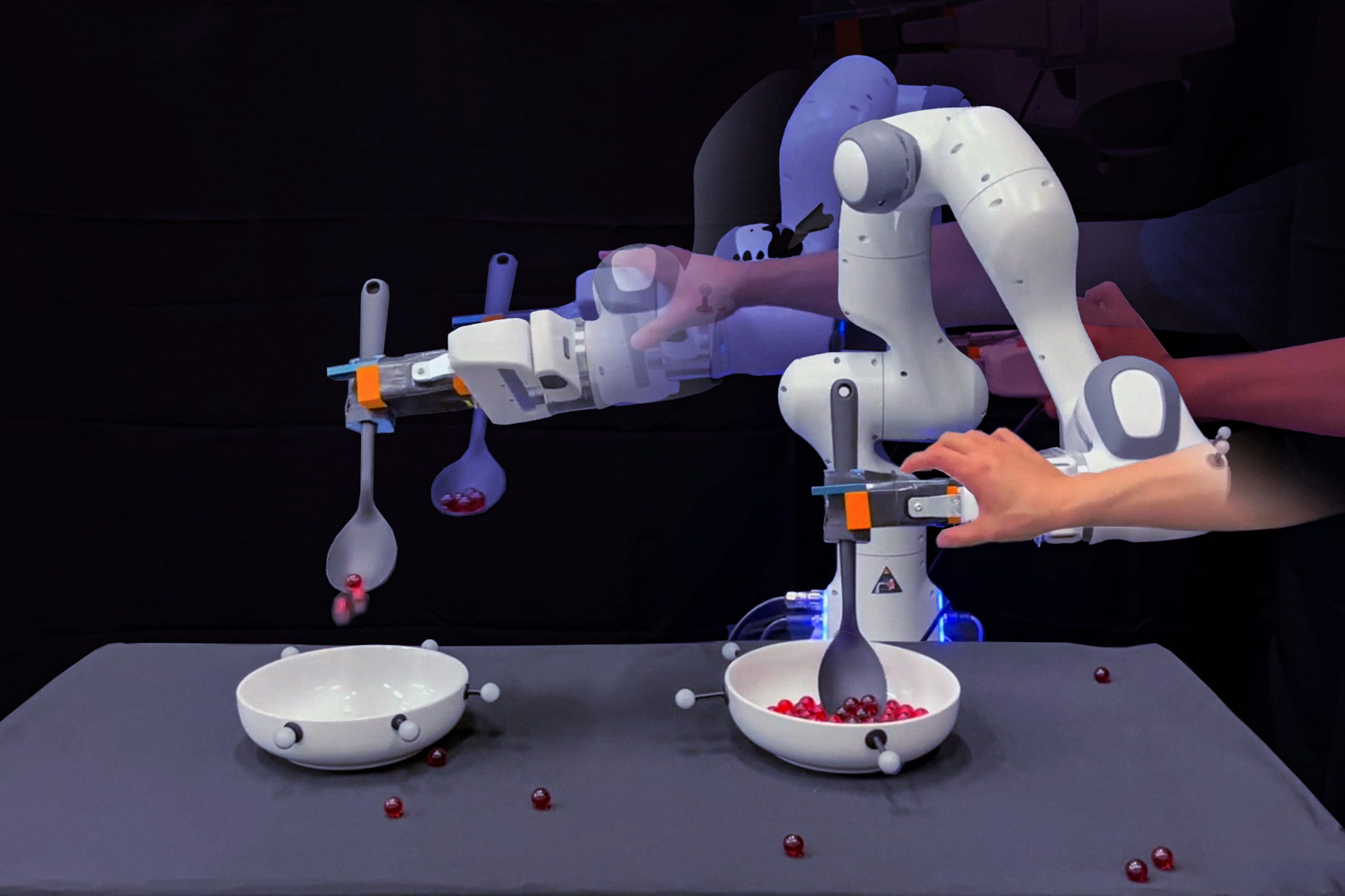

Los investigadores ilustran su nuevo enfoque con una tarea sencilla: sacar canicas de un cuenco y verterlas en otro. Para realizar esta tarea, los ingenieros suelen mover un robot mediante movimientos de recoger y verter, todo ello en un recorrido del líquido. Puedes hacer esto varias veces para darle al robot una serie de actuaciones humanas para imitar.

«Pero la demostración humana es una trayectoria larga y continua», dice Wang.

El equipo se dio cuenta de que, aunque un humano podía demostrar una sola tarea a la vez, esa tarea depende de una secuencia de subtareas o trayectorias. Por ejemplo, el robot primero debe meter la mano en un cuenco antes de poder sacar, y debe recoger canicas antes de poder pasar al cuenco vacío, y así sucesivamente. Si un robot es empujado o empujado a cometer un error en una de estas subtareas, su único recurso es detenerse y comenzar de nuevo, a menos que los ingenieros tengan que etiquetar explícitamente cada subtarea y programar o recopilar nuevas demostraciones para que el robot pueda recuperarse. dicho fallo con el fin de darle a un robot la oportunidad de corregirse en el momento.

«Este nivel de planificación es muy laborioso», afirma Wang.

En cambio, él y sus colegas descubrieron que los LLM podrían realizar parte de este trabajo automáticamente. Estos modelos de aprendizaje profundo procesan bibliotecas masivas de texto, que utilizan para crear conexiones entre palabras, oraciones y párrafos. A través de estas conexiones, un LLM puede generar nuevas oraciones basadas en lo que ha aprendido sobre el tipo de palabra que probablemente seguirá a la última.

Por su parte, los investigadores descubrieron que, además de oraciones y párrafos, a un LLM se le puede pedir que cree una lista lógica de subtareas que estarían involucradas en una tarea determinada. Por ejemplo, si se le pide que enumere las acciones involucradas en sacar canicas de un tazón a otro, un LLM podría producir una secuencia de verbos como «alcanzar», «sacar», «transportar» y «verter».

“Los LLM tienen la capacidad de indicarle en lenguaje natural cómo completar cada paso de una tarea. La demostración continua de una persona es la encarnación de estos pasos en el espacio físico”, dice Wang. «Y queríamos combinar los dos para que un robot sepa automáticamente en qué fase de una tarea se encuentra y pueda replanificar y recuperarse por sí solo».

Mapeo de canicas

Para su nuevo enfoque, el equipo desarrolló un algoritmo para asociar automáticamente la etiqueta de lenguaje natural de un LLM para una subtarea específica con la posición de un robot en el espacio físico o una imagen que codifica el estado del robot. Mapear las coordenadas físicas de un robot o una imagen del estado del robot a una etiqueta de lenguaje natural se llama «conexión a tierra». El nuevo algoritmo del equipo está diseñado para aprender un «clasificador» básico. Esto significa que aprende a reconocer automáticamente en qué subtarea semántica se encuentra un robot (por ejemplo, «alcanzar» o «sacar») en función de sus coordenadas físicas o de una vista de imagen.

«El clasificador de conexión a tierra facilita este diálogo entre lo que hace el robot en el espacio físico y lo que el LLM sabe sobre las subtareas y las limitaciones a las que debe prestar atención dentro de cada subtarea», explica Wang.

El equipo demostró este enfoque en experimentos con un brazo robótico que entrenaron en una tarea de palear canicas. Los experimentadores entrenaron al robot guiándolo físicamente en la tarea de meter la mano en un cuenco, recoger canicas, transportarlas sobre un cuenco vacío y verterlas en él. Después de algunas demostraciones, el equipo utilizó un LLM previamente entrenado e interrogó al modelo para enumerar los pasos necesarios para sacar canicas de un cuenco a otro. Luego, los investigadores utilizaron su nuevo algoritmo para conectar las subtareas definidas del LLM con los datos de la trayectoria del robot. El algoritmo aprendió automáticamente a asignar las coordenadas físicas del robot en las trayectorias y la vista de imagen correspondiente a una subtarea específica.

Luego, el equipo hizo que el robot realizara la tarea de extracción de forma independiente utilizando los clasificadores de conexión a tierra recién aprendidos. A medida que el robot avanzaba en cada paso de la tarea, los experimentadores empujaron y empujaron al robot fuera de su camino y arrojaron canicas de su cuchara en varios puntos. En lugar de detenerse y empezar de nuevo o continuar a ciegas sin canicas en la cuchara, el robot pudo corregirse y completar cada subtarea antes de pasar a la siguiente. (Por ejemplo, esto garantizaría que las canicas se recojan con éxito antes de transportarlas al recipiente vacío).

«Si el robot comete errores con nuestro método, no necesitamos pedirle a la gente que programe ni hacer demostraciones adicionales sobre cómo corregir errores», dice Wang. “Esto es muy emocionante porque ahora se está haciendo un gran esfuerzo para entrenar robots domésticos con datos recopilados mediante sistemas de teleoperación. Nuestro algoritmo ahora puede convertir estos datos de entrenamiento en un comportamiento robótico robusto que puede completar tareas complejas a pesar de las perturbaciones externas”.

[ad_2]

New Comments